Existe un cierto pavor ante la amenaza que los drones representan para nuestra privacidad. En efecto, este tipo de aviones no tripulados están ya preparados para el mercado doméstico y masivo: en EE.UU. una nueva ley obliga a las aerolíneas a compartir el cielo con drones para uso comercial, para decepción del lobby que hacía campaña a la contra. No es sorprendente que los fabricantes tradicionales de aviones comiencen a mirar a estos drones con ojos de nuevo mercado.

Desde el punto de vista de la privacidad, lo interesante de los drones viene si nos acordamos de Barbra Streisand, convertida en meme cuando en 2003 intentó censurar unas fotografías aéreas de su casa en California.

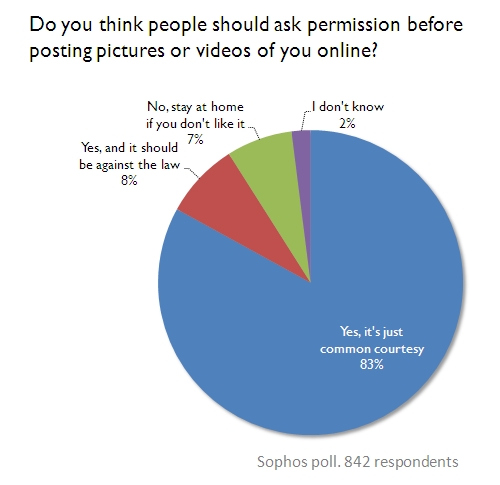

En efecto, frente a la pasividad mostrada ante la erosión de nuestra privacidad en la Red (recuerden que lo divertido del gran gazpacho de datos que hará Google el próximo 1 de marzo no es que crucen sus bases de datos, sino que les diéramos los datos en primer término), los drones nos recuerdan las peores distopías que leímos y leeremos y dan algo de miedo. Por ese motivo hay quien opina que los drones tendrán un efecto diferente a la web y sí dispararán una defensa de la privacidad.

No lo tengo claro, y creo que si hay un catalizador en este ámbito es el móvil (de Carrier IQ a Path y el abuso de los datos del usuario, no hay mes que no haya un escándalo de dimensiones épicas), pero sí que creo que en los próximos tiempos veremos cómo en torno a los drones aparece una densa regulación en la que éstos serán equiparados al mal, en la línea en que se ha tratado desde su mismo nacimiento al p2p y otras tecnologías que han caído en manos de las personas antes de que puedan ser controladas por quienes aspiran a distorsionar a su favor la vida pública.