Desde que Malcolm Gladwell publicara The Tipping Point hace una década, los argumentos contenidos en ese libro han sido aderezo imprescindible para toda campaña de comunicación online, incluso para aquellas que no pasaban de ser marketing aburrido (o agotador, como la recurrente y repetida búsqueda del «viral» a toda costa). El enfoque es sencillo: detectemos a los individuos influyentes en un ámbito, sumémoslos a nuestra causa y su prestigio hará el resto. Mientras este planteamiento parece correcto (quizá porque llevamos una década manejándolo), ¿qué sucedería si la propagación de un meme no estuviera relacionada con la reputación o la influencia del emisor sino con otros parámetros que no estamos contemplando? Recientemente no uno sino dos trabajos parecen apuntar en esta idea: uno pone la carga de la propagación en el receptor del mensaje y otro en la topología de la red.

Los nodos centralizadores

Malcolm Gladwell parte de la idea de que en una red hay nodos que actúan como hubs actuando de conectores entre unos y otros. Así, para llevar un mensaje desde A hasta C no podemos ir de cualquier forma, sino que necesitamos pasar por B, que actúa como conector. En su argumentación, los nodos que al igual que el B de nuestro ejemplo actúan como conectores masivos son los que con más probabilidad pueden ayudar a que nuestro mensaje alcance la masa crítica necesaria para asegurar su propagación. Acceder a ellos sería La clave del éxito, que es como algún traductor creativo tradujo el título de la obra de Gladwell.

Pero, ¿y si la propagación de una noticia o un meme no estuviera relacionado con la reputación o la influencia del emisor sino con otros parámetros? Todo parece indicar que sucede exactamente eso y que los parámetros relevantes no son la influencia del emisor, sino la influenciabilidad del receptor y la topología de la red que estemos analizando y en la que deseemos comunicarnos.

De los «6 grados de separación» al Tipping Point… y vuelta atrás

El primero de los apuntes en esta línea lo proporcionaba Duncan Watts, teórico de redes que fuera profesor en la Universidad de Columbia y ahora trabaja para Yahoo!. Watts no estaba convencido del modelo de Gladwell, así que organizó por su cuenta una repetición masiva del clásico experimento de Milgram que dio origen a la regla de los «seis grados de separación». Según nos contaron en FastCompany:

«But Watts, for one, didn’t think the gatekeeper model was true. It certainly didn’t match what he’d found studying networks. So he decided to test it in the real world by remounting the Milgram experiment on a massive scale. In 2001, Watts used a Web site to recruit about 61,000 people, then asked them to ferry messages to 18 targets worldwide. Sure enough, he found that Milgram was right: The average length of the chain was roughly six links. But when he examined these pathways, he found that «hubs»–highly connected people–weren’t crucial. Sure, they existed. But only 5% of the email messages passed through one of these superconnectors. The rest of the messages moved through society in much more democratic paths, zipping from one weakly connected individual to another, until they arrived at the target.»

Aquí una referencias al trabajo de Watts en Scientific American, ya en el 2003. El experimento de Watts corroboró los seis grados de separación de Milgram, pero levantó en él otras dudas. Por supuesto que descubrió algunos nodos centralizadores que aglutinan más mensajes que otros (esta centralidad irregular seguramente es inevitable en una red compuesta por personas), lo que sucede es que en su experimento los mismos tenían un rol menos concentrador que lo que Gladwell había sugerido. Un 5% es un 5%, pero si ha de traernos una idea a la mente es que es sólo un 5%.

Watts concluye que para la propagación de un mensaje no es tan relevante la autoridad del emisor como la capacidad del receptor de ser influido. Es mucho es más importante cuán influenciable es el público objetivo del meme.

La no importancia acerca del emisor

Un artículo publicado en Nature hace apenas 3 semanas va más allá, referenciando un trabajo publicado en 2004 en Physical Review E:

A closer analogy to our approach is perhaps provided by neutral models of ecosystems, where individuals (posts) belonging to different species (memes) produce offspring in an environment (our collective attention) that can sustain only a limited number of individuals. At every generation, individuals belonging to new species enter the ecosystem while as many individuals die as needed to maintain the sustainability threshold.

Esa definición en clave estocástica de lo que no es sino un juego de suma cero lleva a Bianka Hajdu a afirmar que:

«Twitter se comporta como los medios de masas, donde para la popularidad también es más importante el medio y su estructura (qué medio leo y quién más lo lee, a quién sigo, a quién retuiteo sin leer qué) que el mensaje y donde dinámicas como la polarización de grupo campan a sus anchas.»

Buscando las diferencias… y las similitudes

En efecto, la principal diferencia entre el estudio de Milgram en 1967 y el de Watts en 2001 es este maravilloso y nuevo entorno que llamamos Internet. Y si hay un fenómeno característico de Internet ése es la desintermediación en todos los ámbitos (desde la distribución de contenidos a la de alimentos). Así, no es sorprendente que en los albores del siglo que vivimos y llevando su experimento a la web, Watts encontrara una red mucho menos centralizada que la que encontrara Milgram en el Brooklyn analógico de 1967.

No obstante, el hecho de que esa «Competición entre memes en un mundo de atención reducida» de Weng et al. perciba Twitter como un juego de suma cero nos recuerda que la promesa de Internet se ha hecho realidad pero a mucha menor escala de lo que creíamos. Internet prometía cambiar las cosas mediante la redistribución del poder y la adquisición de autonomía por parte de las personas, sin embargo tienen razón quienes afirman que las cosas han cambiado menos en estos últimos cinco años que lo que lo hicieron los cinco anteriores. El cambio radical hay que buscarlo en la disminución de la barrera de entrada para acceder a, crear y cuidar un público que oiga tu mensaje.

El empoderamiento condicionado por las herramientas

Debemos evitar concluir, en todo caso, que Internet fue un bluf. Más bien debemos observar bien los detalles sobre los que hablamos para darnos cuenta que Internet es mucho más que eso y que algunas de estas conclusiones podrían modificar sus enunciados si tomamos para nuestro estudio un sistema de composición diferente.

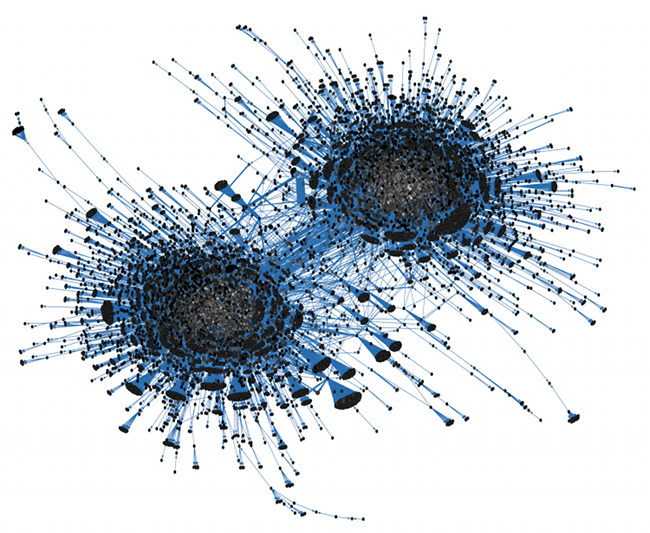

Tanto el estudio de Nature como el post de Kids en Blogoff versan sobre Twitter. La imagen que acompaña a este post está sacada de ese trabajo y representa la propagación del hashtag #gop (me parece irrelevante usar #syria o #egypt para expresar la topología de la protesta en esos países –y aunque quede claro que hacen otra cosa, es lo que sugiere intuitivamente la gráfica–, pues dudo que el idioma inglés fuera predominante en las protestas que el año pasado nos recordaron la existencia de un gran oriente medio).

Y es que ya sabemos que el diseño de la herramienta condiciona lo que podemos hacer con ella. Twitter está pensado para centralizar audiencias y es una de las caras más visibles de la tabletización aplicada a servicios web, motivo por el que es aclamada por los medios «tradicionales»: abre una vía para la migración acrítica (que no cuestiona el modelo tradicional) desde la lectura de los medios masivos en analógico a su lectura en digital, sin obligarnos (cómo si lo hacen otras herramientas en la Red) a preguntarnos si otra manera de comunicarnos es posible ni extender las nuevas formas de creación que Internet hace accesibles para todos. Por supuesto, aún es posible adquirir autonomía para personas y organizaciones, pero es un proceso de formación continua y consciente, no el fruto de la casualidad ni del devenir entrópico del universo.

Al tomar como modelo sistemas que desaprovechan (por sencilla desestimación, ni siquiera las tenemos en cuenta) las oportunidades que Internet ofrece en favor de un status quo del modelo anterior, estos estudios dejan abierta la puerta a una mirada que refine los resultados.

Conclusiones: de Watts a Weng al analista de redes

Pero si hay una idea clara en todo esto es que la labor del analista de redes es crucial. Hace años que hablamos de la periferia de la red como ese lugar donde habita el 50% de las personas y al que no se accede desde los nodos masivos, y así lo expreso cuando doy seminarios sobre el tema. Watts apunta a que un sistema que no ha sido previamente tamizado por una herramienta concreta, cuyo diseño sirve para recentralizar, podría estar mucho más disperso.

Por supuesto que aún vale la pena detectar los nombres influyentes, un 5% es más que un 0%, pero si algo se deduce de todos estos estudios es que la labor del analista de redes, conocedor de las dinámicas y los flujos de información en un medio concreto, son aún más valiosas de lo que habíamos supuesto en un principio. Los penalties existen, pero no podemos confiar el éxito de un proyecto a una carta única que pase por contar con el apoyo de una cierta personalidad o la aparición en una serie de medios de comunicación de masas: al final, parece que la clave del éxito era otra. Estudiar una red y su comportamiento nos abre más puertas que una serie de nombres, y ya sabemos que para eso no sirven (todavía) las máquinas.